摘要:,,Scaling Law的边界挑战是当前人工智能领域的重要议题。随着深度学习技术的不断发展,基座大模型在人工智能领域的应用越来越广泛。如何寻找基座大模型的未来方向,仍是一个亟待解决的问题。本文探讨了Scaling Law的边界挑战,并提出了寻找基座大模型未来方向的一些思考,包括探索更高效的模型结构、优化训练方法和应用场景的拓展等方面。只有不断探索和尝试,才能为基座大模型的未来发展提供更多可能性。

本文目录导读:

在人工智能的领域中,Scaling Law已经成为了一个重要的概念,随着深度学习技术的不断发展,基座大模型在各种任务中发挥着越来越重要的作用,随着模型规模的扩大和复杂性的增加,Scaling Law是否会“撞墙”的问题逐渐浮现,本文将探讨Scaling Law的边界挑战以及如何找到基座大模型的未来方向。

Scaling Law的背景与意义

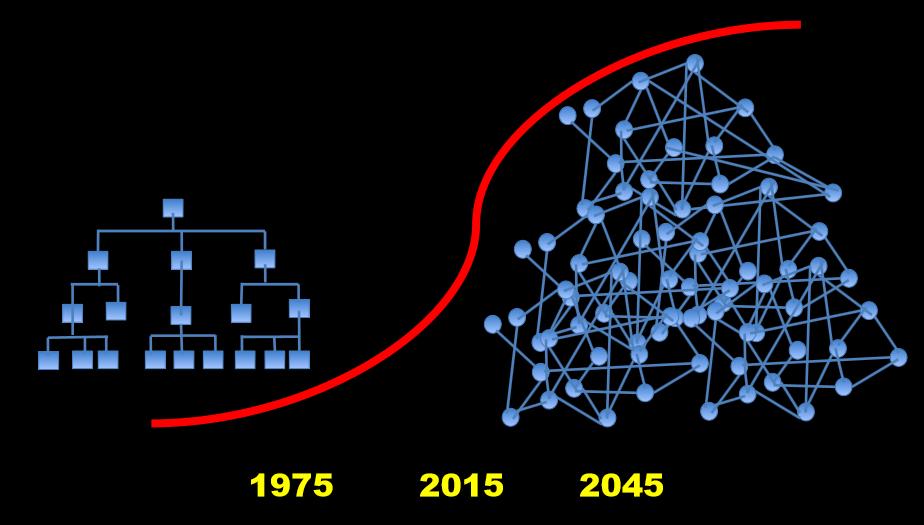

我们来了解一下Scaling Law,Scaling Law是近年来在深度学习中出现的一个概念,它主要描述了模型规模与性能之间的关系,随着模型规模的扩大,其性能也会随之提升,但这种提升并不是无限制的,Scaling Law为我们提供了一个理论框架,帮助我们理解模型规模与性能之间的关系,并指导我们如何选择合适的模型规模。

在人工智能领域,基座大模型的应用越来越广泛,从自然语言处理到计算机视觉,从语音识别到推荐系统,基座大模型都发挥着重要作用,理解Scaling Law对于我们探索基座大模型的未来方向具有重要意义。

Scaling Law的边界挑战

随着模型规模的扩大,Scaling Law也面临着一些边界挑战,随着模型规模的增加,计算资源的需求也会急剧上升,这导致了许多研究者不得不面对高昂的计算成本和漫长的训练时间,过大的模型规模可能导致过拟合问题,使得模型在新的数据集上表现不佳,随着数据隐私和安全问题的日益严重,如何在保护隐私的同时利用大规模数据进行模型训练也成为了一个重要的挑战。

如何找到基座大模型的未来方向

面对Scaling Law的边界挑战,我们需要从多个方面来寻找基座大模型的未来方向。

1、优化计算资源:随着技术的发展,我们可以尝试使用更高效的硬件和软件来降低计算成本,利用分布式计算和云计算技术,将多个计算节点连接起来共同完成模型的训练任务,研究者们还可以探索新型的计算架构和算法,以降低模型的计算复杂度。

2、探索模型压缩与剪枝技术:为了降低计算成本和内存需求,我们可以研究模型压缩与剪枝技术,通过减少模型的参数数量和深度,我们可以在保持模型性能的同时降低其计算复杂度,这些技术可以帮助我们在有限的计算资源下实现更好的模型性能。

3、关注数据隐私与安全:在利用大规模数据进行模型训练的同时,我们需要关注数据隐私与安全问题,通过使用加密技术和匿名化处理方法,我们可以保护用户的隐私数据免受泄露之虞,我们还需研究如何在保护隐私的同时充分利用数据进行模型训练,以实现更好的性能。

4、跨领域融合:基座大模型在各个领域都有广泛的应用前景,我们可以尝试将不同领域的基座大模型进行融合,以实现更强大的功能,将自然语言处理和计算机视觉技术相结合,可以开发出更智能的图像识别和描述系统,我们还可以探索与其他人工智能技术的融合,如强化学习、知识图谱等,以实现更全面的智能应用。

5、持续研究与探索:我们需要持续关注Scaling Law的研究进展和技术发展,通过不断探索新的算法和技术,我们可以更好地理解基座大模型的性能与规模之间的关系,并找到更有效的模型优化方法,我们还需要关注行业需求和市场变化,以确定基座大模型在未来的发展方向和应用领域。

面对Scaling Law的边界挑战和未来发展方向的探索任务,我们需要从多个方面入手进行研究和探索,通过优化计算资源、探索模型压缩与剪枝技术、关注数据隐私与安全、跨领域融合以及持续研究与探索等措施的实施我们将能够更好地应对这些挑战并找到基座大模型的未来发展方向为人工智能领域的发展做出更大的贡献。

浙ICP备2021030560号

浙ICP备2021030560号